В чем проблема

Google заявила, что сократила и ускорила ответы, а ИИ на самом деле реагировал на статические картинки, а не на изображение с камеры, которая смотрела на движения человека. Пользователи, уже успевшие испытать новинку, обратили внимание на проблемы Gemini и недовольны его способностями – система неправильно отвечает на вопросы и не умеет анализировать информацию так, как это показано в ролике.

Смотрите также Google запускает мощную модель искусственного интеллекта Gemini, которая должна победить ChatGPT-4

Ролик с демонстрацией возможностей опубликован на официальном канале Google. Честно говоря, он действительно впечатляющий в некоторых моментах. Если бы это было правдой.

Gemini демонстрирует свои якобы способности: видео

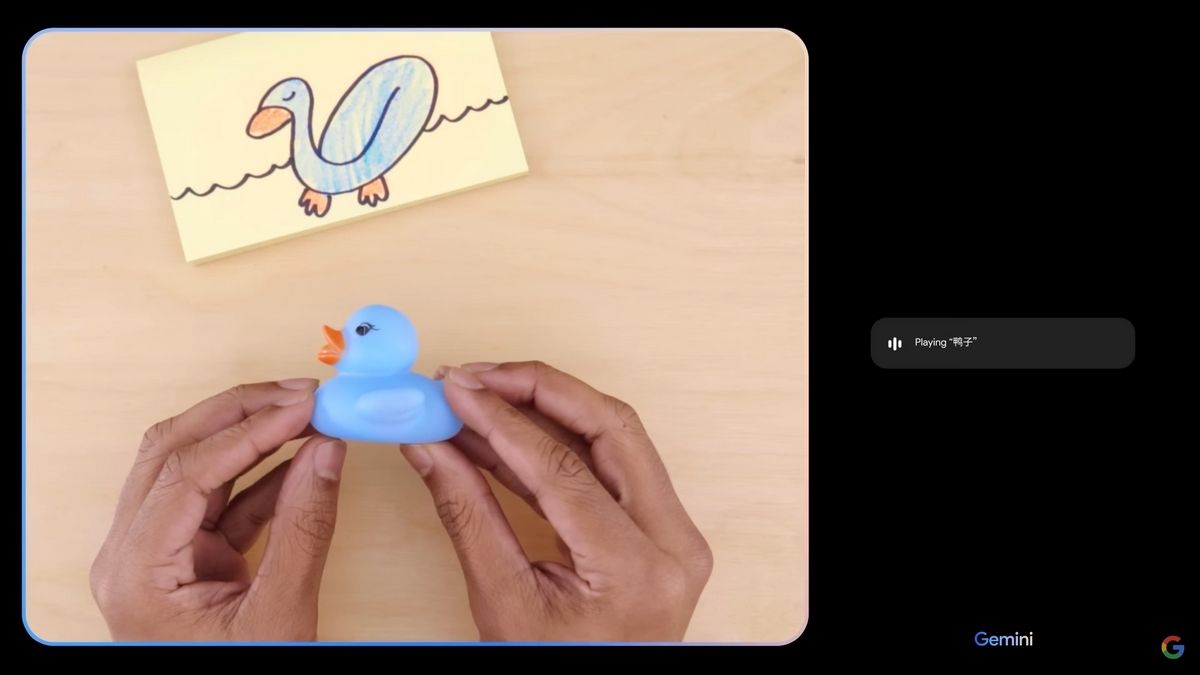

В видео сотрудник компании показывает модели различные рисунки, фото и видео, а она быстро угадывает, что изображено на них или что произойдет дальше. Большинство ответов правильные и похожи на человеческие, что очень впечатлило зрителей. К тому же искусственный интеллект общается с человеком голосом, как в обычной беседе.

Теперь в Google признали, что на самом деле показывали Gemini статические изображения и вводили текстовые запросы. Речевая модель не воспринимала аудиозапись с человеческой речью и отвечала дольше, чем в ролике. Она еще не умеет анализировать видео, поэтому ей показывали отдельные скриншоты из них. Кроме того, сотрудники компании сократили и отредактировали ответы. Таким образом, хотя Gemini и могла генерировать показанные в видео реплики, она делала это не в реальном времени и не так, как подразумевалось в демонстрации.

Промо-ролик сильно преувеличивает нынешние способности Gemini. Разработчики признались, что пока что их детище не превосходит GPT-4, как было неоднократно заявлено, а примерно соответствует GPT-3,5.

После такой рекламы у пользователей были завышенные ожидания от работы обновленного чат-бота Bard, который уже "улучшили" с помощью интеграции Gemini Pro. Но он не соответствует этим ожиданиям. ИИ-помощник неправильно отвечает на вопросы, придумывает несуществующие факты и события, плохо справляется с любыми языками, кроме английского, и предлагает собеседникам самостоятельно погуглить новости. Например, он не может назвать победителей премии "Оскар" 2023 года, хотя модель интегрирована с "Google Поиском" и "Google Новостями", поэтому должен комментировать и резюмировать новости, как это делает GPT-4. Однако вместо этого чат-бот предлагает пользователям искать информацию самостоятельно.

Кроме того, любознательные пользователи Google уже успели найти способы "взлома" модели, позволяющие обойти защитные фильтры и заставить ее раскрыть общественно опасную информацию. Сейчас она крайне уязвима для злоумышленников, которые пытаются выманить внутренние данные компании или узнать, как изготовить взрывчатку в домашних условиях.