В чому проблема

Google заявила, що скоротила та прискорила відповіді, а ШІ насправді реагував на статичні картинки, а не на зображення з камери, яка дивилася на рухи людини. Користувачі, які вже встигли випробувати новинку, звернули увагу на проблеми Gemini і незадоволені його здібностями – система неправильно відповідає на питання і не вміє аналізувати інформацію так, як це показано в ролику.

Дивіться також Google запускає потужну модель штучного інтелекту Gemini, яка повинна перемогти ChatGPT-4

Ролик із демонстрацією можливостей був опублікований на офіційному каналі Google. Правду кажучи, він дійсно вражаючий у деяких моментах. Якби це було правдою.

Gemini демонструє свої нібито здібності: відео

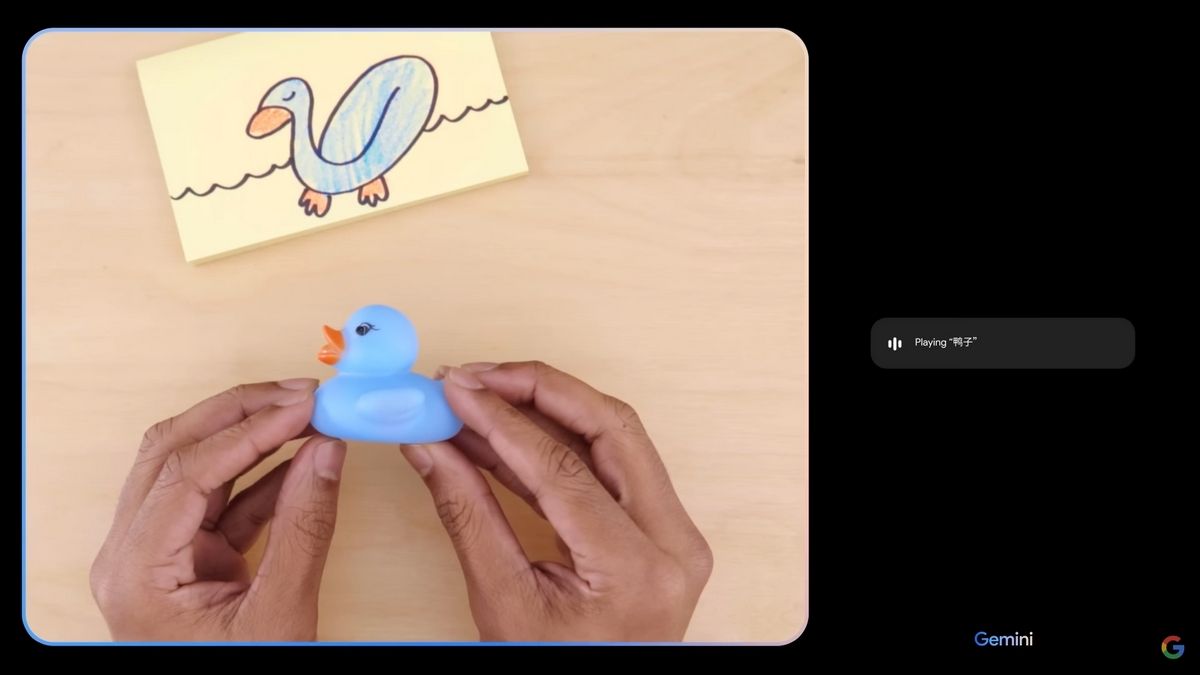

У відео співробітник компанії показує моделі різні малюнки, фото і відео, а вона швидко вгадує, що зображено на них або що станеться далі. Більшість відповідей правильні та схожі на людські, що дуже вразило глядачів. До того ж штучний інтелект спілкується з людиною голосом, наче у звичайній бесіді.

Тепер у Google визнали, що насправді показували Gemini статичні зображення та вводили текстові запити. Мовна модель не сприймала аудіозапис із людською мовою та відповідала довше, ніж у ролику. Вона ще не вміє аналізувати відео, тому їй показували окремі скриншоти з них. Крім того, співробітники компанії скоротили й відредагували відповіді. Таким чином, хоча Gemini і могла генерувати показані у відео репліки, вона робила це не в реальному часі та не так, як малося на увазі в демонстрації.

Промо-ролик сильно перебільшує нинішні здібності Gemini. Розробники зізналися, що поки що їхнє дітище не перевершує GPT-4, як було неодноразово заявлено, а приблизно відповідає GPT-3,5. Gemini Ultra, найбільш просунута версія моделі, яка зможе конкурувати з продуктом OpenAI, вийде тільки наступного року.

Після такої реклами у користувачів були завищені очікування від роботи оновленого чат-боту Bard, який вже "покращили" за допомогою інтеграції Gemini Pro. Але він не відповідає цим очікуванням. ШІ-помічник неправильно відповідає на запитання, вигадує нереальні факти й події, погано справляється з будь-якими мовами, окрім англійської, і пропонує співрозмовникам самостійно погуглити новини. Наприклад, він не може назвати переможців премії "Оскар" 2023 року, хоча модель інтегрована з "Google Пошуком" і "Google Новинами", тож має коментувати та резюмувати новини, як це робить GPT-4. Однак замість цього чат-бот пропонує користувачам шукати інформацію самостійно.

Крім того, допитливі користувачі Google уже встигли віднайти способи "зламу" моделі, що дають змогу обійти захисні фільтри та змусити її розкрити суспільно небезпечну інформацію. Наразі вона вкрай вразлива для зловмисників, які намагаються виманити внутрішні дані компанії або дізнатися, як виготовити вибухівку в домашніх умовах.