Впервые о способности ChatGPT распознавать и интерпретировать визуальный ввод компания OpenAI объявила в мае 2024 года, но ее развертывание столкнулось с многочисленными задержками, сообщает 24 Канал со ссылкой на TechCrunch.

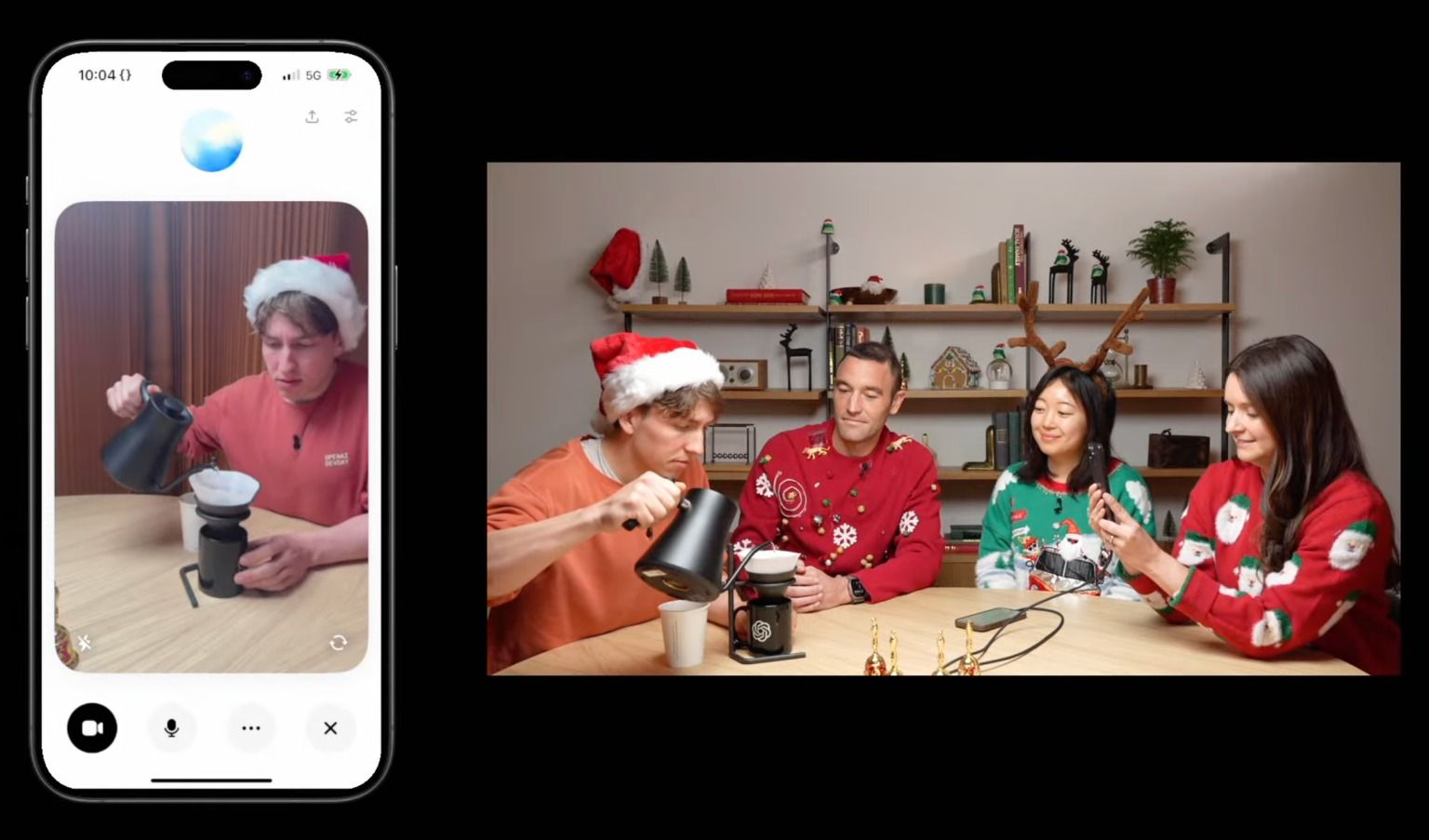

А тем временем Голосовой режим вашего ChatGPT теперь может звучать как Санта

Сначала компания пообещала, что пользователи получат доступ к этой функции "в течение нескольких недель", но официально она стала доступной только 12 декабря 2024 года. Сейчас доступ к ней получили только платные подписчики планов ChatGPT Plus, Team и Pro.

Пользователям ChatGPT Enterprise и Edu придется подождать до января 2025 года.

Что дает новая функция?

Новая функция была недавно продемонстрирована в программе CNN "60 минут". Во время эфира президент OpenAI Грег Брокман протестировал технологию с телеведущим Андерсоном Купером. Купер нарисовал на доске анатомические части тела, которые ChatGPT успешно распознала.

Однако, когда перед ним встала геометрическая задача, ChatGPT совершил ошибку, продемонстрировав свою склонность к галлюцинациям – известное ограничение моделей искусственного интеллекта.

Развертывание возможностей визуального распознавания ChatGPT рассматривается как конкурентный шаг против Google и Meta, которые работают над аналогичными функциями для своих чат-ботов.

На этой неделе Google объявил о выпуске Project Astra, инструмента ИИ, способного анализировать видеопотоки в реальном времени, который сейчас доступен для избранной группы доверенных тестировщиков на Android.

Смотрите также iOS 18․2 с функциями Apple Intelligence наконец вышла: как изменится ваш iPhone

Для OpenAI предоставить возможность "видеть" своему инструменту означает значительное развитие интерактивности ChatGPT, выводя его за рамки текстового и голосового общения в пространство, где он может взаимодействовать с пользователями визуально.

Эта функция может открыть новые возможности для интерактивного обучения, творческой помощи и задач поддержки, хотя ошибки, встречающиеся в ней, подчеркивают постоянные вызовы в развитии ИИ.