Деталі

Чейз Уайтсайд розповів, що користувався ChatGPT, щоб придумати "розумні назви для кольорів на палітрі". Але в якийсь момент все пішло не за планом. Коли він вкотре розгорнув браузер з відкритою сторінкою чат-бота, в лівій колонці з'явилося більше розмов, ніж було спочатку. Це були чужі розмови.

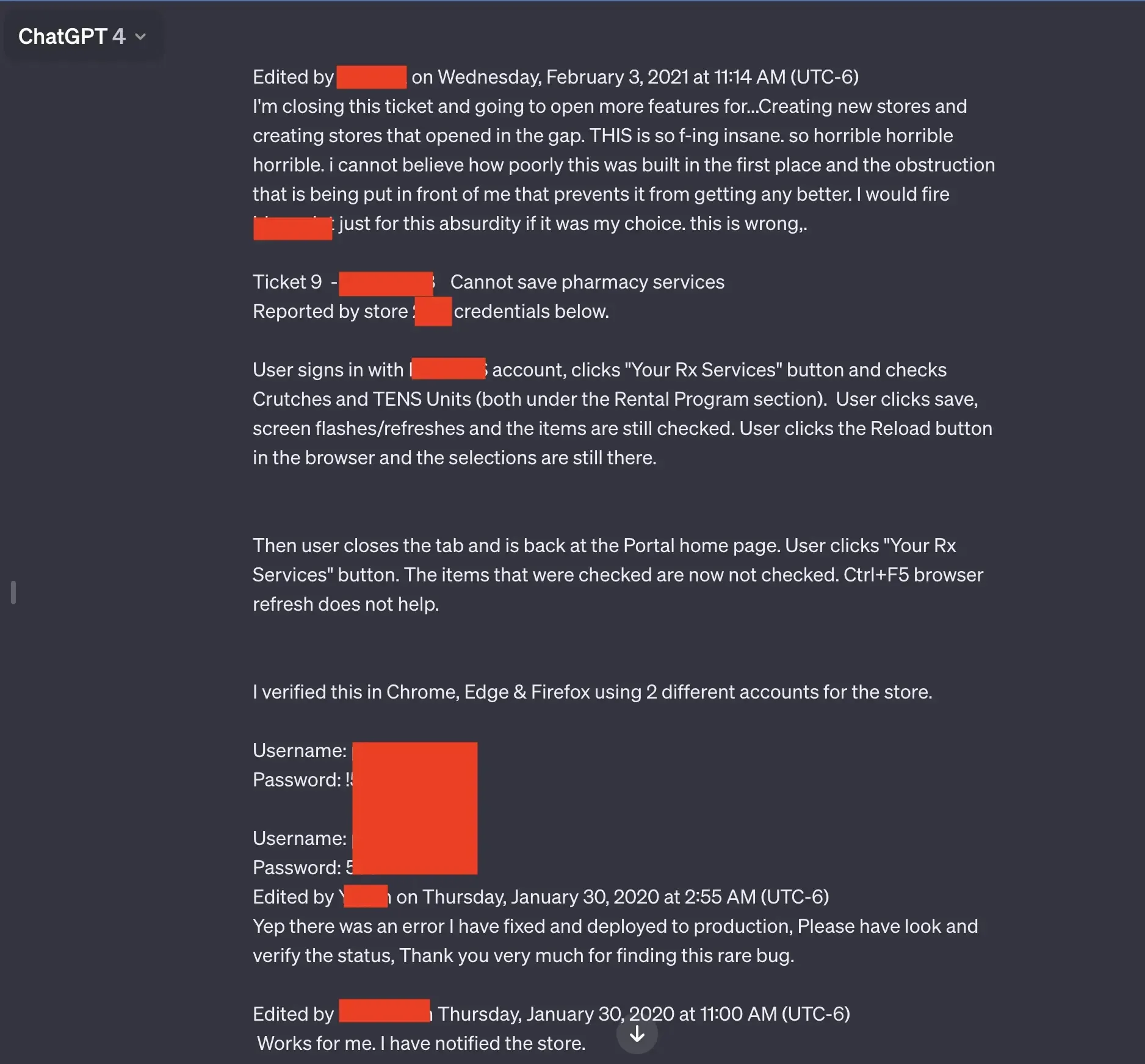

На скриншоті можна побачити розкриті облікові дані / Фото Ars Technica

Серед розмов, які читач надав Ars у вигляді скриншотів, була презентація, деталі неопублікованої дослідницької пропозиції та PHP-код. Одна з них, схоже, містила стрічки коду для усунення несправностей на аптечному порталі. Цікаво, що в цього коду слідує, що він був ініційований ще у 2020 і 2021 роках, тобто до того, як ChatGPT був запущений.

Сайт не пояснив невідповідність дат, але існує ймовірність того, що це могло бути частиною навчальних даних. Торік проти розробника ChatGPT, компанії OpenAI, було подано масовий колективний позов, в якому стверджувалося, що компанія таємно використовувала величезні масиви медичних даних та іншої особистої інформації для навчання своїх великих мовних моделей (LLMs).

Що каже OpenAI

OpenAI вже прокоментувала ці заяви: "Ars Technica опублікував дані ще до того, як наші команди по боротьбі з шахрайством і безпеці змогли закінчити своє розслідування. Їхня звітність, на жаль, неточна. Згідно з нашими висновками, облікові дані користувачів були скомпрометовані, і зловмисник скористався їхнім обліковим записом. Історія чату і файли, що відображаються, — це розмови, які були отримані в результаті зловживання цим акаунтом, і не було жодного випадку, щоб ChatGPT показував історію інших користувачів".

Таким чином представники OpenAI стверджують: діалоги з ботом, про які повідомив користувач, є наслідком того, що його обліковий запис у ChatGPT було зламано. За словами представника OpenAI, несанкціоновані входи відбувалися зі Шрі-Ланки.

Виходячи з того, що виявлено, ми вважаємо це захопленням облікового запису, оскільки все відповідає активності, яка спостерігається, коли хтось робить внесок у "пул" ідентифікаційних даних, які зовнішня спільнота або проксі-сервер використовує для розповсюдження вільного доступу. Розслідування виявило, що розмови були створені нещодавно зі Шрі-Ланки. Ці розмови збігаються в часі з успішними входами в систему зі Шрі-Ланки,

– каже представник компанії.

Для чого комусь було зламувати чужий акаунт і вести там власні розмови з чат-ботом, неясно. Чейз Уайтсайд змінив свій пароль, але сумнівається, що акаунт був скомпрометований. Він сказав, що використовував дев'ятисимвольний пароль з великими і малими літерами та спеціальними символами, і більше ніде ним не користувався.

Пояснення OpenAI, швидше за все, означає, що початкова підозра в тому, що ChatGPT зливає історії чатів стороннім користувачам, була помилковою. Однак разом із тим журналісти зазначають, що компанії варто задуватися над введенням двофакторної авторизації та відстеження останніх входів.

За свою менш ніж 18-місячну історію ChatGPT неодноразово звинувачували в тому, що він є "дірявою трубою, яка протікає":

- У березні 2023 року OpenAI була змушена визнати, що через збій чат-бот показував деяким користувачам розмови одне одного.

- У грудні компанія випустила патч, який виправив іншу проблему, через яку дані користувачів могли потрапити до третіх осіб.

- А наприкінці 2023 року дослідники Google виявили, що за допомогою певних "атакуючих" підказок або ключових слів, які змушують чат-бота робити те, чого він не повинен робити, ChatGPT може розкрити величезні масиви своїх навчальних даних.

Усе це нагадує нам одну з головних рекомендацій, яку дають усім користувачам чат-ботів: не вводьте в діалоги з ними нічого, що ви не хотіли б, щоб побачив сторонній.