Об этом сообщает arXiv.org.

Читайте также: Робота научили мыть туалет

Ученые из Научно-исследовательского института электроники и телекоммуникаций (ETRI) и Корейского института передовых технологий (KAIST) решили научить робота невербальной коммуникации – жестам. Для этого они собрали датасет из 52 часов записи выступлений спикеров на конференциях TED Talks.

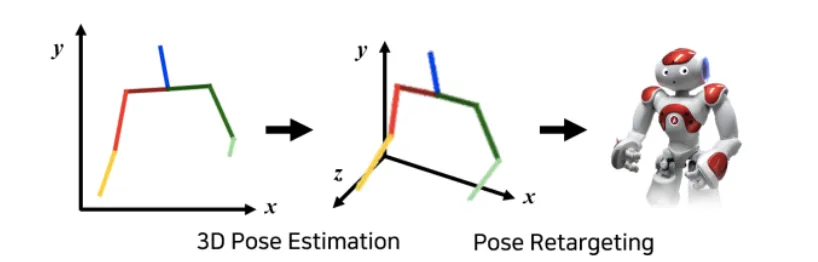

Жесты людей на видео были размечены с помощью открытого алгоритма OpenPose (использовались только движения головы, торса и рук). В результате получилась система, которая воспроизводит положение тела в трехмерном пространстве в соответствии с синтезированной речью.

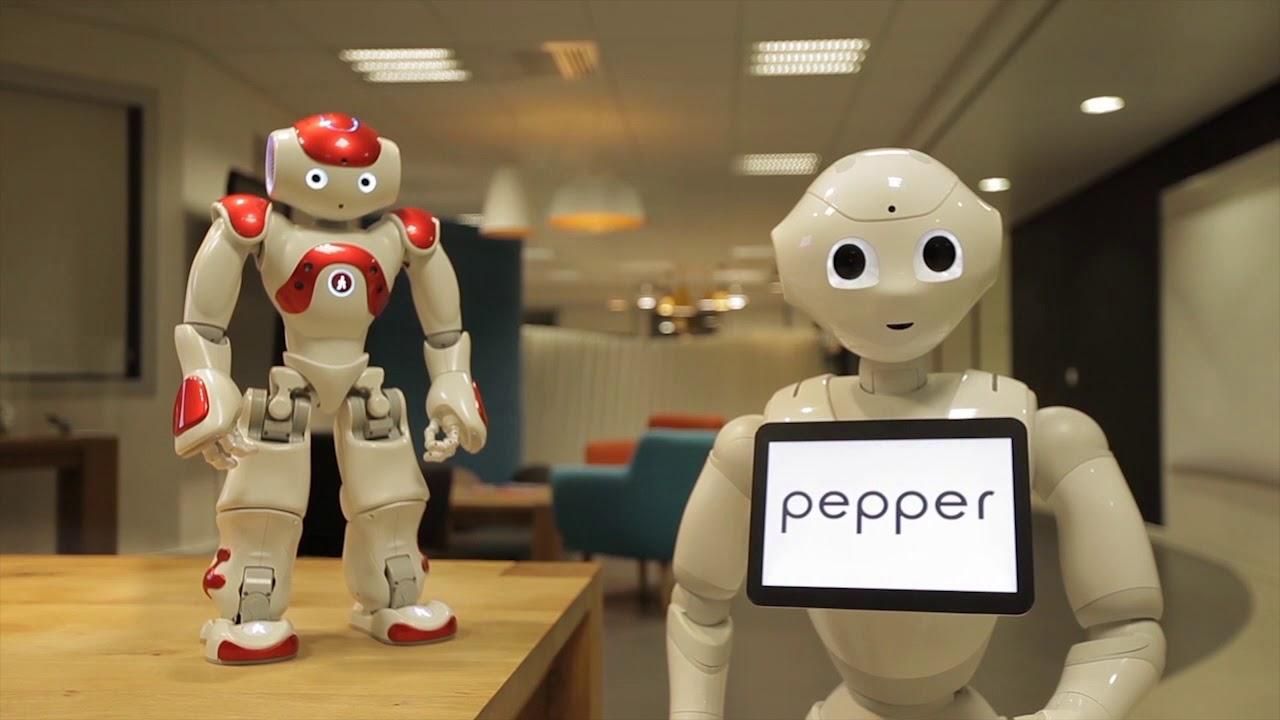

Робот NAO научился воспроизводить речь жестами

Затем ученые попросили 46 человек оценить по шкале от 1 до 5, насколько жесты, сопровождающие язык, антропоморфные, соответствуют сказанному и приятны на вид. Оказалось, что воспроизведеннsе алгоритмом жесты превзошли по всем параметрам все другие методы.

Читайте также: В Китае ведущим стал искусственный интеллект: как он выглядит

Полученную систему использовали в гуманоидном роботе NAO (он часто используется в исследованиях взаимодействия роботов с людьми): авторы робота утверждают, что нейросети удалось успешно воспроизвести заданные ему комбинации движений.

Больше новостей, касающихся событий из мира технологий, гаджетов, искусственного интеллекта, а также космоса читайте в разделе Техно